Publicado por UOL TAB em 04/6/2016

Texto de Juliana Carpanez e Direção de Arte de Andre Alcalay.

Quando quis agilizar o processo de seleção de novos alunos, a tradicional faculdade britânica de medicina St. George usou um software para definir quem deveria ser entrevistado. Ao reproduzir a forma como os funcionários faziam essa escolha, o programa eliminou, de cara, 60 de 2.000 candidatos. Só por causa dosexo ou origem racial, numa dedução baseada em sobrenome e local de nascimento. Um estudo sobre o caso foi publicado em 1988, mas, 25 anos depois, outra pesquisa apontou que esse tipo de discriminação segue firme. O exemplo recente envolve o buscador do Google: ao digitar nomes comuns entre negros dos EUA, a chance de os anúncios automáticos oferecerem checagem de antecedentes criminais pode aumentar 25%. Para piorar, com a pergunta “arrested?” (detido?) logo após a palavra procurada.

Casos como esses escancaram que a tecnologia tem reproduzido comportamentos preconceituosos dos quais a maioria diz não se orgulhar. Já são inúmeras as provas de como essas ferramentas estão cada vez melhores em imitar, também, o nosso pior lado. Quando se baseiam em nomes para segregar pessoas, por exemplo, os softwares mostram que qualquer semelhança com a realidade não é mera coincidência. Um levantamento recente indica que, nos EUA, hóspedes com nomes comuns entre negros – como Aisha, Keisha, Tyrone e Leroy – têm 16% menos chances de sucesso no site Airbnb (com exceção dos nomes, os perfis usados nos testes eram idênticos). E aqui não dá para culpar a tecnologia: a decisão de aceitar ou recusar os pedidos de locação cabia somente aos proprietários dos imóveis.

NA MIRA

Os humanos dão o mau exemplo, a máquina repete. Uma situação preocupante, à medida que o preconceito ganha agora esse “reforço técnico” para ser propagado. A questão virou desafio para gente grande, como mostra um relatório divulgado em maio pelo governo dos EUA. “O big data [captura e análise de grandes volumes de dados] está cheio de riscos. Os algoritmos podem transformar dados em informações que não são infalíveis – baseiam-se na imperfeição de inserções, da lógica, da probabilidade e das pessoas que os desenvolvem. […] Sem cuidado, essas inovações podem facilmente promover a discriminação, reforçar vieses e mascarar oportunidades.”

É o lado ruim de ferramentas cada vez mais presentes, que se usadas adequadamente podem ajudar na comprovação e combate do preconceito que muitos negam existir. “O big data chegou para ficar. A questão é como será usada: para promover os direitos civis e oportunidades ou enfraquecê-los”, questiona o documento.

Sem que você necessariamente tenha se dado conta, os algoritmos tornaram-se grandes curadores de sua vida digital. Por causa deles, plataformas como Facebook, YouTube e Netflix mostram aquilo que você possivelmente quer ver. O Google tenta adivinhar a continuação da frase enquanto você a digita. Os anúncios exibidos na sua tela são personalizados, aumentando as chances de cliques. Fica tudo mais fácil, mais à mão. Mas também mais viciado. Nesse contexto, os algoritmos acabam refletindo preconceitos do comportamento humano (o software descrito no início deste TAB, por exemplo, eliminou minorias ao seguir um padrão executado por recrutadores em anos anteriores).

Esse viés também pode vir dos desenvolvedores do programa ou dos dados que o alimentam. Professor adjunto do Departamento de Ciência da Computação da Universidade do Arizona (EUA), o brasileiro Carlos Scheidegger dá um exemplo de como o enviesamento pode tomar forma. Se um modelo para prever quem será usuário de drogas for alimentado com dados sobre a população carcerária, a incidência de usuários será maior entre os negros. Mas isso não representa a realidade. “O que acontece é que mais negros são detidos pelo uso de drogas. Nesse caso, o algoritmo estaria discriminando esse grupo, da mesma forma que o sistema judiciário já faz”, explica. “É uma área de pesquisa nova e o problema é complicado. Os pesquisadores estão trabalhando em soluções que combinem computação, direito e sociologia”, continua.

O problema aparece em outras versões no livro “The Formula: How Algorithms Solve All Our Problems – and Create More” (“A Fórmula: Como os Algoritmos Resolvem Todos os Nossos Problemas – e Criam Mais”, em tradução livre). Caso das pessoas identificadas como terroristas em potencial nos aeroportos norte-americanos – o algoritmo, aqui, está associado a um sistema de impressões digitais. Um piloto da American Airlines, conta o autor Luke Dormehl, foi interceptado 80 vezes em um ano por esse motivo (um garoto de quatro anos também foi vítima do engano). E tem o sistema de recomendação da loja de aplicativos Google Play, que dá uma sugestão polêmica para os usuários gays. Fez o download do aplicativo de encontros Grindr? Baixe também esse programa que aponta a localização de predadores sexuais. Ops.

Grande parte do desafio se deve à forma como lidamos – ou não lidamos – com o preconceito. Com exceção de alguns grupos, pouquíssimos são aqueles que admitem esse tipo de sentimento. Menos ainda são aqueles que se orgulham abertamente dele. Mas esse comportamento existe e se manifesta diariamente, ainda que de forma velada. Estruturas binárias, ao contrário dos humanos, escancaram essa realidade quando um casal de negros é identificado como gorilas pela ferramenta de tags do Google Photos. Ou um recurso parecido da plataforma de fotos Flickr identifica negros como macacos. As empresas não estavam de sacanagem: o que seus algoritmos fizeram foi reproduzir, sem o filtro da cordialidade, o recorrente discurso do “não sou preconceituoso, mas…”.

Não é fácil apontar culpados quando complexos programas de computador, todo trabalhados em interação e aprendizado, agem de forma preconceituosa. A dificuldade em identificar a fonte do problema ficou clara em um estudo da Universidade de Carnegie Mellon (EUA), que indica como os anúncios online de recolocação aparecem mais para os homens quando se tratam de vagas com melhor remuneração.

Foi esta a conclusão dos pesquisadores: “Não consideramos que leis ou políticas foram burladas. Inclusive as regras do Google permitem exibir propagandas com base no sexo. Além disso, não podemos determinar se o Google, o anunciante ou uma complexa interação causou esse resultado. […] Levando em conta a segregação de gênero na sociedade, encontrar um só culpado seria ignorar o contexto e as correlações que permitem evitar essa discriminação”. O desafio é ainda maior se considerada a falta de transparência envolvendo algoritmos – você pode deduzir por que Google e Facebook lhe mostram certo tipo de conteúdo, mas não conhece o exato funcionamento dessas ferramentas. É como jogar um jogo sem saber as regras.

Apesar de o estudo citado acima ser norte-americano, esse comportamento sexista também fica evidente no Brasil. É o que mostra o artigo “Mulher negra em terra de homem branco: mecanismos de reprodução de desigualdades”, de Eliane Barbosa da Conceição, professora do curso de administração pública da Unilab (Universidade da Integração Internacional da Lusofonia Afro-Brasileira).

No artigo, ela usa como base a seguinte divisão da sociedade: mulheres negras, mulheres brancas, homens negros e homens brancos. E aponta o tipo preferido de profissional nas sociedades capitalistas: homem branco, adulto, heterossexual, das classes médias e altas, que tenha recebido uma educação formal considerada de qualidade. Se fugir desse perfil, a vida profissional pode ficar mais difícil – se muito ou pouco, dependerá de quanto essa pessoa se encaixa em outros grupos. Assim, a mulher negra pertence, de cara, ao grupo mais prejudicado.

“De acordo com os padrões da sociedade brasileira, é ‘natural’ que a mulher negra ocupe posições subordinadas e de pouca relevância, dado o lugar que ocupa na própria hierarquia social. Um dos resultados mais perversos desse processo determina para a mulher negra o baixo retorno do seu investimento em qualificação”, diz o artigo, trazendo para o offline aquilo que os algoritmos estão praticando no universo digital (se o praticam é porque assim foram “ensinados”, gerando um sistema em looping).

Muito antes de a tecnologia virar protagonista, a economia já servia de termômetro para medir quanto uma sociedade é preconceituosa. “O teste real vem nos momentos de dificuldade econômica. Quando a renda cai, as pessoas procuram bodes expiatórios. Não gostamos de perder aquilo que conquistamos e colocamos no outro a culpa por nossas mazelas”, diz Antonio Carlos Alves Dos Santos, professor titular do departamento de economia e coordenador do Comitê de Ética em Pesquisa da PUC-SP (Pontifícia Universidade Católica de São Paulo). “Nessas situações, é possível saber se o preconceito diminuiu ou se a sociedade apenas fingia ser tolerante. Uma forma de simular essa aceitação é criando guetos de imigrantes: respeito sua cultura, mas não quero conhecê-la.”

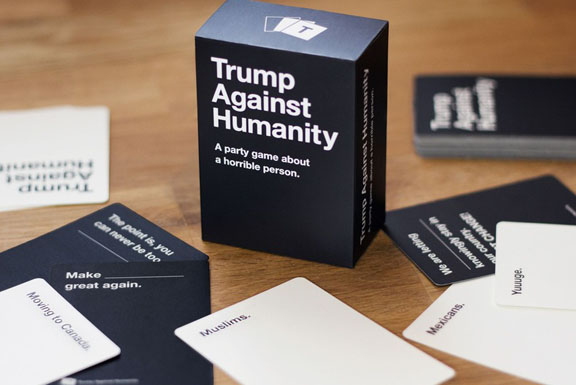

Coordenador do Laep (Laboratório de Estudos Sobre o Preconceito), da Universidade de São Paulo, o psicólogo José Leon Crochík explica que na crise as pessoas mais atingidas tendem a exagerar na sua avaliação em relação às outras. No caso da imigração, por exemplo, pode haver mais restrições diante da alta disputa por empregos. “O medo é a base mais importante para o desenvolvimento de preconceitos. Em momentos de dificuldade, quem não tem preconceitos tende a desenvolvê-los. Quem já tem tende a acirrá-los”, define Crochík. Basta lembrar dos muitos brasileiros barrados na Espanha quando a situação econômica do país se agravou, depois de 2008. Ou da recente decisão do Reino Unido de deixar a União Europeia. Ou da posição anti-migração do candidato presidencial dos EUA Donald Trump.

Um levantamento feito pela consultoria norte-americana UBS, em 2011, relaciona diretamente o nível de discriminação à competitividade e ao desenvolvimento econômico de um país. O principal motivo seria o desperdício de mão-de-obra: aqueles que sofrem preconceito deixam de atingir seu potencial máximo como trabalhadores e, portanto, a sociedade não se beneficia de toda a contribuição que poderia vir desse indivíduo. “Em outras palavras, o desenvolvimento econômico influencia o preconceito, e o preconceito influencia o crescimento econômico”, resume Paul Donovan, economista responsável pelo relatório.

Donovan também aponta diferenças nos tipos de discriminação. Racismo e homofobia seriam fortes em países menos competitivos; intolerância religiosa e xenofobia aparecem mais nas economias de competitividade média.

Impossível negar a força do preconceito, em pleno 2016 e no mundo ocidental, quando 49 pessoas são assassinadas apenas por frequentarem uma boate gay – no velório de uma das vítimas, em Orlando (EUA), ainda foi preciso impedirmanifestações de um grupo declaradamente homofóbico. Por outro lado, também são inegáveis as inúmeras iniciativas para aumentar a tolerância e coibir a discriminação – no Reino Unido, a campanha #safetypin propõe o uso de um alfinete na região do peito para sinalizar que aquela pessoa não representa uma ameaça contra os imigrantes. Nesse tipo de luta, é importante que os algoritmos não sejam usados como ferramenta para reforçar um problema tão enraizado nas mais distintas culturas.

Admitir que a tecnologia repete comportamentos discriminatórios é um começo, pois permite lidar diretamente com o problema num mundo conectado. Para Scheidegger, o fato de as empresas reforçarem a diversidade em suas equipes também ajuda a prevenir problemas. Um exemplo: a câmera de um notebook da HP acompanhava os movimentos e seguia o usuário. Mas o recurso não funcionava para negros. “Certamente não foi de propósito, porém o algoritmo não deve ter sido testado entre pessoas de pele escura. Se o time de engenharia fosse mais diverso, o problema poderia ter sido detectado antes de a máquina chegar ao mercado”, diz.

Em seu relatório, o governo norte-americano defende a colaboração entre os setores públicos e privados para evitar a discriminação. Na prática, a Casa Branca propõe a realização de pesquisas sobre o tema, o desenvolvimento de sistemas que promovam a igualdade, a criação de algoritmos com mecanismos de transparência e testes externos em sistemas de big data para garantir que os usuários sejam tratados de maneira justa. O documento não fala em prazos e, portanto, é possível que as mudanças demorem a ser implementadas.

O diretor de arte Linus Oura e o redator publicitário Tiago Abreu, ambos de 31, não esperaram essas transformações para provar como os algoritmos podem ser recheados de estereótipos. Há um ano, os brasileiros criaram a página People Are Equal (Pessoas São Iguais), que ilustra como a ferramenta autocompletar do Google retrata diversas nacionalidades – com base, claro, nas buscas já feitas por outros usuários. A dupla usa imagens locais cedidas por fotógrafos e mostra as sugestões da ferramenta (em inglês): japoneses são… esquisitos; vietnamitas são… espertos; gregos são… rudes; suecos são… chatos; russos são… as pessoas brancas mais assustadoras; brasileiros são… irritantes.

“Não acreditamos que o Google reforce preconceitos. Ao contrário: as sugestões é que são fruto dos preconceitos e estereótipos. É justamente o senso comum estereotipado que alimenta o algoritmo e faz aquelas respostas aparecerem. O projeto tem uma abordagem simbólica, propondo não a mudança da frase em si, mas a reflexão de como somos preconceituosos”, explicou Tiago Abreu. A ideia é ter uma foto de cada país, mesmo que não exista nenhuma sugestão de autocompletar sobre ele: “Isso mostra que o resto do mundo nem lembra ou nem sabe que ele existe. A ideia é justamente preservar todas essas nuances”.

A tecnologia está aí, onipresente, e pronta para cometer alguns dos erros que a humanidade tenta evitar. Uma alternativa viável, como proposta pelos EUA, é a união de forças para lidar com o problema e eliminar o enviesamento dos dados. Por outro lado, pouco adianta acabar com esse tipo de discriminação digital, caso ela continue existindo nas ruas. Se um ambiente é espelho do outro, pelo menos que esse reflexo não crie tantas distorções como agora. E fica o desafio para os programadores: um software para incentivar a tolerância, o respeito e a diversidade.